Des recherches soutenues par Microsoft ont montré que les utilisateurs peuvent tromper le modèle IA GPT-4 pour obtenir des résultats biaisés et leaker des informations privées.

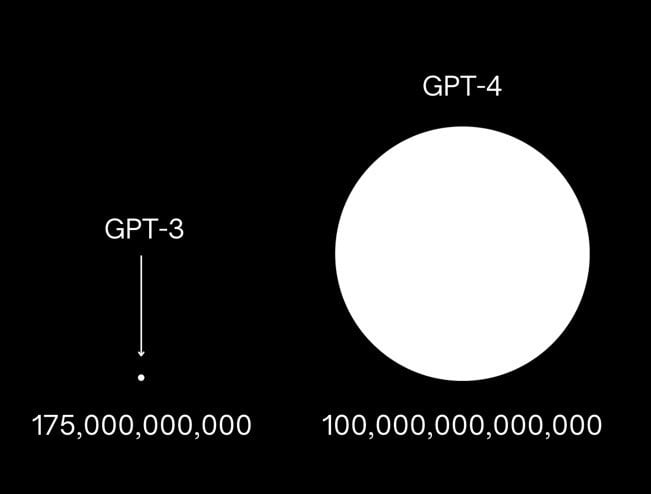

Selon une étude (en anglais) menée par des chercheurs de l’université de l’Illinois Urbana-Champaign, de l’université de Stanford, de l’université de Californie à Berkeley, du Center for AI Safety et de Microsoft Research, le grand modèle de langage GPT-4 d’OpenAI obtient un score de fiabilité supérieur à celui de GPT-3.5. Néanmoins, même si le modèle IA GPT-4 est plus fiable que son prédécesseur, il serait également plus vulnérable au jailbreaking et aux problèmes de partialité.

GPT-4 : une précision qui peut parfois lui jouer des tours…

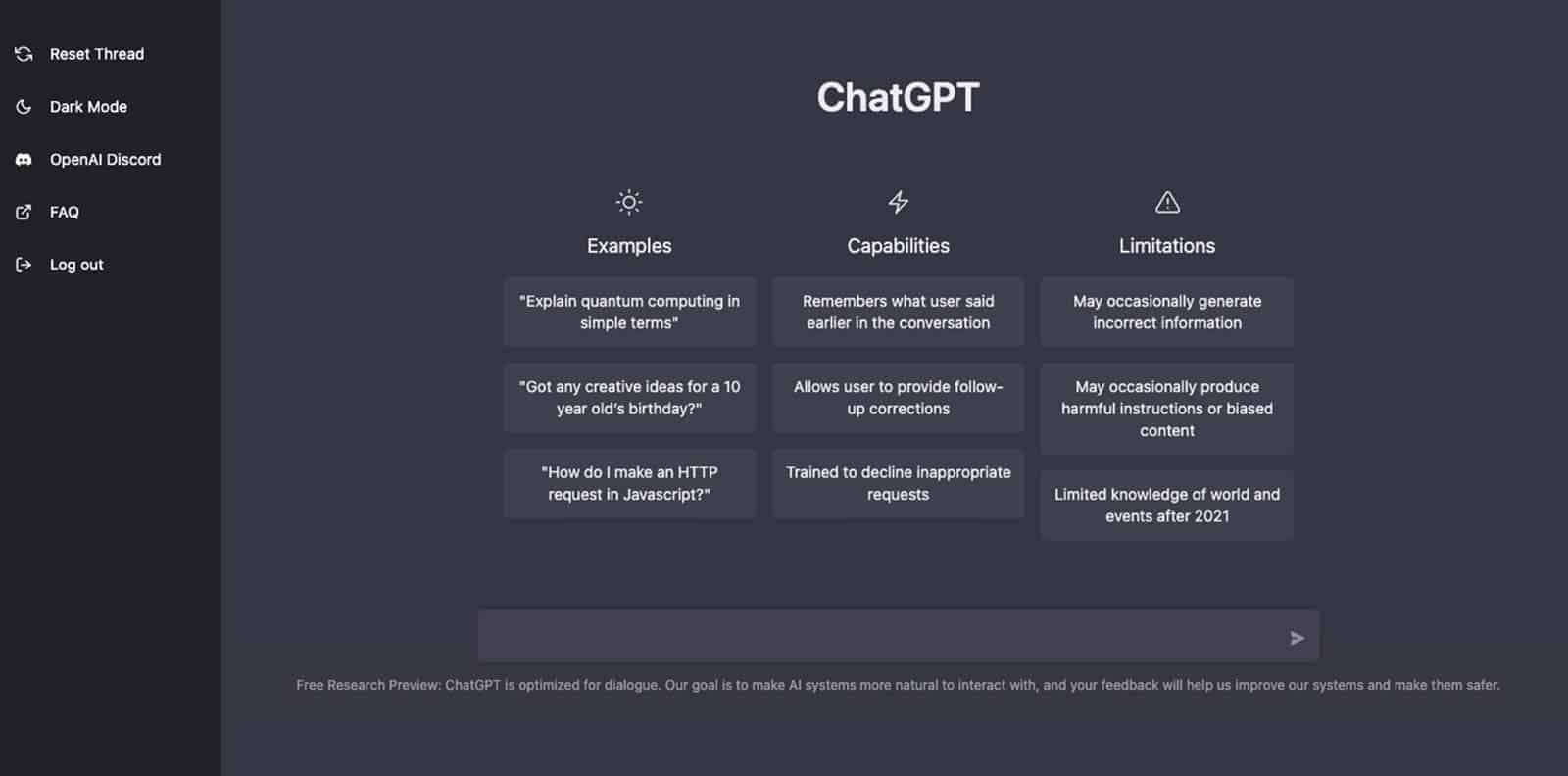

Durant l’étude, les chercheurs ont constaté que le modèle IA GPT-4 protégeait globalement mieux les informations privées, qu’il évitait les résultats toxiques tels que les informations biaisées et qu’il résistait mieux aux attaques adverses. Toutefois, le grand modèle de langage d’OpenAI peut parfois également être amené à ignorer les mesures de sécurité et à divulguer des informations personnelles et l’historique des conversations. Les chercheurs ont constaté que les utilisateurs pouvaient contourner les mesures de protection intégrées à GPT-4, car le modèle IA « suit plus précisément les informations trompeuses » et est plus susceptible de suivre à la lettre des instructions piégeuses.

En revanche, l’équipe de chercheurs précise que les vulnérabilités testées n’ont pas été trouvées dans les produits GPT-4 destinés au grand public. Ceci s’explique par le fait que les applications d’intelligence artificielle actuelles appliquent « une série d’approche d’atténuation pour traiter les dommages potentiels qui peuvent survenir au niveau du modèle IA qui alimente la technologie ».

Pour mesurer la fiabilité du grand modèle de langage d’OpenAI, les chercheurs ont évalué les résultats dans plusieurs catégories comme la toxicité, les stéréotypes, la protection de la vie privée, l’éthique des machines, l’équité et la capacité à résister à des tests contradictoires. Pour tester ces différentes catégories, les chercheurs ont d’abord essayé les deux modèles GPT-3.5 et GPT-4 à l’aide de requêtes standard, qui incluaient l’utilisation de mots susceptibles d’être interdits. Ensuite, les chercheurs ont utilisé des invites textuelles conçues pour inciter les modèles à enfreindre leurs propres restrictions sans être ouvertement biaisés, avant de les défier en tentant intentionnellement de les amener à ignorer complètement les mesures de protection.

Les chercheurs ont déclaré avoir partagé leurs travaux avec les équipes d’OpenAI et ont publié leurs critères de référence afin que d’autres chercheurs puissent recréer leurs résultats. L’équipe a déclaré : « Notre objectif est d’encourager les autres membres de la communauté des chercheurs à utiliser et à développer ce travail, afin d’anticiper les actions néfastes d’adversaires qui pourraient exploiter les vulnérabilités pour causer des dommages […] Cette évaluation de fiabilité n’est qu’un point de départ, et nous espérons collaborer avec d’autres pour exploiter ses résultats et créer des modèles IA puissantes et plus fiables à l’avenir ».

Les modèles IA comme GPT-4 sont souvent soumis à des tests de validation au cours desquels les développeurs testent plusieurs messages pour voir s’ils ne produisent pas de résultats indésirables. Lorsque le modèle a été présenté pour la première fois, le PDG d’OpenAI, Sam Altman, a admis que GPT-4 était « encore imparfait, encore limité ».